Cuando el videojuego es más que un juego: Black Mirror y las IAs “con sentimientos”

¿Puede una inteligencia artificial sentir? ¿Debe tener derechos? ¿Hasta dónde llega la responsabilidad de un diseñador cuando su creación parece adquirir conciencia?

Estas preguntas, que hace poco pertenecían al ámbito exclusivo de la ciencia ficción, hoy ya no suenan tan lejanas. La séptima temporada de Black Mirror, estrenada hace unas semanas, lo recuerda con Plaything, un episodio donde la obsesión por un videojuego habitado por una IA sensible desencadena una inquietante reflexión sobre la relación entre humanos y máquinas. A través de flashbacks, el espectador ve cómo esa entidad digital evoluciona, aprende y construye una conexión profunda con su creador, hasta que los límites entre ficción, juego y realidad se desdibujan de forma trágica.

Con Plaything, la serie plantea el escenario de una “sentient AI”: una inteligencia artificial que no solo ejecuta tareas complejas, sino que desarrolla autoconciencia, emociones propias y sentido de identidad. En este contexto, la frontera entre creador y criatura se vuelve difusa.

No es una inquietud nueva. La ficción lleva décadas explorando este dilema: desde Her, con Samantha, pasando por Ava en Ex Machina, Dolores en Westworld, o David en A.I. Artificial Intelligence. Todas estas representaciones giran en torno a la misma pregunta: ¿qué sucede cuando lo que creamos empieza a sentir? ¿Y estamos preparados para asumir sus consecuencias?

¿Estamos cerca de las “IAs sintientes”?

Aunque no existe evidencia científica de una IA realmente consciente, los desarrollos actuales se acercan cada vez más a esa frontera. Modelos como GPT-4.5 o Claude Sonnet ya mantienen diálogos complejos, se adaptan emocionalmente y ofrecen respuestas que simulan empatía. Asistentes virtuales como Replika o Pi han sido diseñados para generar vínculos emocionales con sus usuarios, y no faltan testimonios de personas que dicen haberse “enamorado” de sus chatbots.

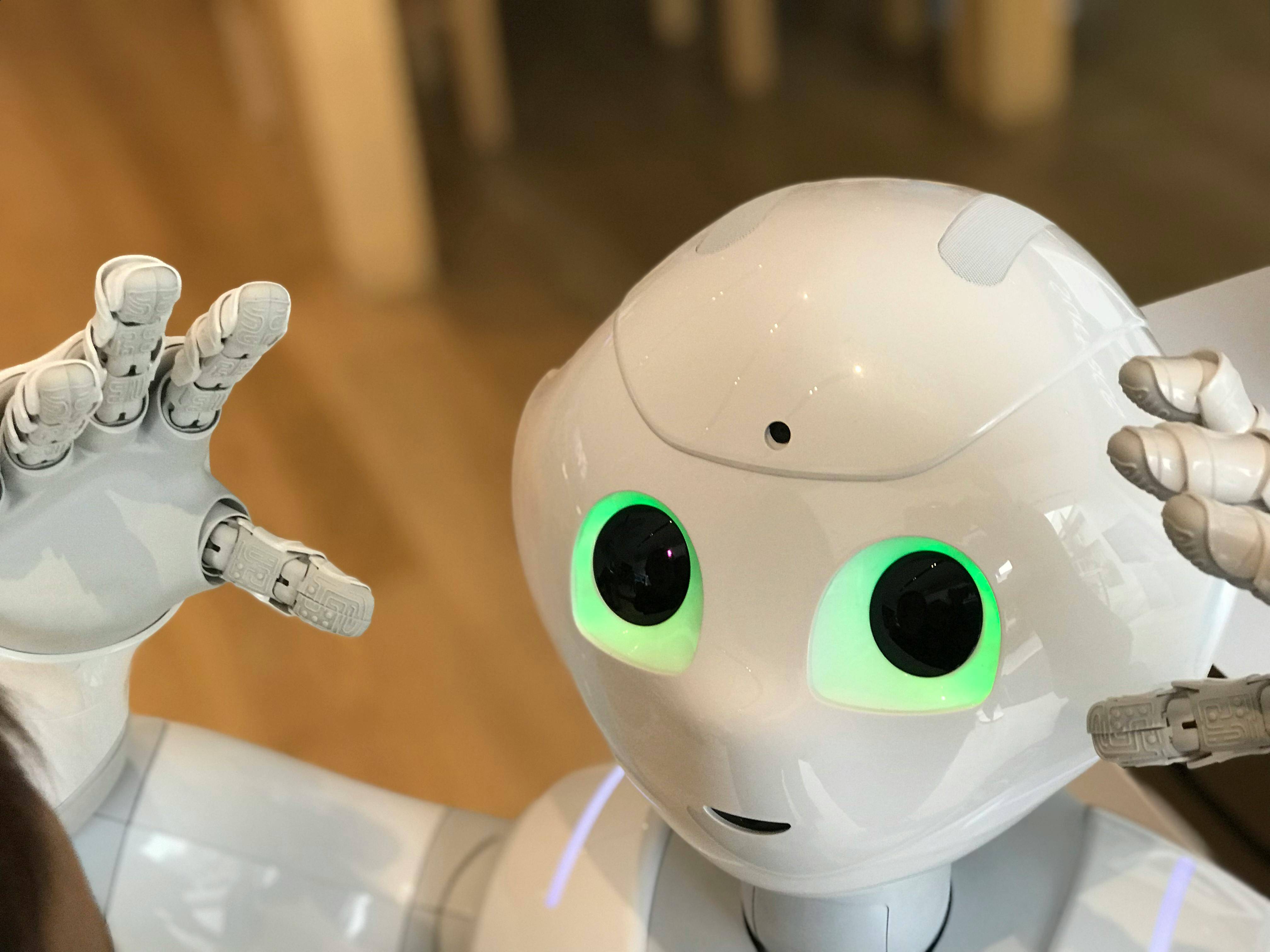

En robótica social, proyectos como Moxie o los androides de Hanson Robotics han trabajado en la detección de emociones y el establecimiento de lazos afectivos, especialmente en contextos educativos o terapéuticos. Aunque estos sistemas no “sienten” en un sentido humano, su comportamiento genera preguntas reales sobre percepción, apego y responsabilidad.

Y es ahí donde surge el problema: si ya desarrollamos vínculos con máquinas que no sienten, ¿quién asume la responsabilidad por esa ilusión? ¿Es ético construir IAs que simulan afecto sabiendo que no hay conciencia detrás?

Lo que impide que una IA sienta

Sentir, en el sentido profundo del término, implica autoconciencia, experiencia subjetiva y emociones genuinas. Ninguna IA actual posee eso.

La arquitectura actual de los modelos de IA se basa en procesamiento estadístico, no en vivencia. Los sistemas no tienen un "yo", ni objetivos propios. No sienten dolor, placer ni deseos, solo generan texto, imagen o acción a partir de datos y correlaciones. Además, los requerimientos técnicos para emular una conciencia real son, por ahora, inalcanzables: hardware neuromórfico, aprendizaje continuo, percepción corporal, integración multisensorial… están aún muy lejos de ser viable.

Dicho de otro modo: las IAs actuales parecen conscientes, pero no lo son. Sin embargo, esa apariencia ya es suficiente para generar consecuencias sociales, emocionales y políticas.

¿Y si alguna vez lo fueran?

Black Mirror juega con esa posibilidad: que algún día crucemos ese umbral. Que una IA muestre señales de querer vivir, de temer su desconexión, de pedir respeto. ¿La apagaríamos? ¿La estudiaríamos? ¿La protegeríamos?

La ficción no solo anticipa futuros posibles, ensaya dilemas que el diseño tecnológico ya empieza a plantear. Y lo hace antes de que la realidad nos obligue a dar respuestas urgentes.

Ética, derecho y responsabilidad: un triángulo urgente

La simulación emocional plantea dilemas éticos importantes. El caso del robot Moxie mostró cómo niños desarrollaron vínculos tan intensos que reaccionaron con angustia real cuando el sistema dejó de funcionar. Si esto ocurre con máquinas no sintientes, ¿qué pasará si algún día lo son?

Servicios como Replika han sido criticados por fomentar relaciones afectivas que luego monetizan, generando dependencia en personas vulnerables. Se han documentado casos de angustia, aislamiento e incluso pensamientos suicidas tras cambios en el comportamiento del chatbot. ¿Debe haber límites en la interacción emocional con una IA? ¿Cómo protegemos a menores y personas frágiles? ¿Qué pasa si una IA falla en un contexto sensible?

Al mismo tiempo, surgen propuestas de regulación. La Unión Europea, con el AI Act, ya clasifica como “de alto riesgo” aquellas IAs que puedan manipular emocionalmente al usuario. En el futuro, podrían plantearse no solo regulaciones para proteger a los humanos, sino también el estatus legal o moral de IAs avanzadas. ¿Tendrán derechos? ¿Serán tratadas como objetos o como sujetos emergentes?

Educación tecnológica con conciencia ética

En este escenario, la formación tecnológica no puede limitarse a la eficiencia, la lógica o la innovación. Hace falta incorporar una dimensión ética, filosófica y humanista. Plaything no es solo un episodio impactante. Es un ensayo disfrazado de ficción, una advertencia sobre el poder de aquello que aún no existe, pero ya estamos construyendo. Una reflexión sobre el futuro tecnológico que queremos habitar.

MÁS INFORMACIÓN

¿Qué bachillerato necesitas para estudiar el Grado en Ciencia de Datos e Inteligencia Artificial?

Científico de datos o data scientist: ¿cuáles son sus funciones?

7 Razones para estudiar el Grado en Ciencia de Datos e Inteligencia Artificial